Biasanya saya menggunakan analisis faktor adalah untuk mereduksi sejumlah n-variabel menjadi m-faktor unik, dimana m<n. AKan tetapi m-faktor tersebut bisa menyerap sebagian besar informasi yang terkandung dalam n-variabel asli atau yang bisa memberikan sumbangan terhadap varian seluruh variabel. Dalam analisis faktor tidak terdapat variabel bebas atau pun variabel tak bebas.

Dalan analisis multivariate terdapat dua kelompok model besar, yaitu :

- Model Dependensi, terdapat didalamnya variabel bebas dan variabel tak bebas. Dalam hal ini melihat pengaruh variabel bebas terhadap variabel tak bebas. Dan bahkan hingga meramalkan nilai variabel tak bebas berdasarkan variabel bebas. Contohnya pada analisis regresi, analisis diskriminan, analisis varian, dll.

- Model Interdependensi, tidak terdapat variabel bebas dan variabel tak bebas. Dalam hal ini menganalisis komponen utama berbagai jenis hubungan. Dan semua variabel dan hubungannya dianggap terjadi secara simultan. Contohnya pada analisis faktor dan analisis diskriminan.

Dalam analisis regresi linear berganda sering ditemukan terjadinya multikolinearitas yaitu adanya korelasi antara variabel bebas. Hal ini tentu akan melanggar asumsi dalam regresi linear berganda. Untuk itu, salah satu cara yang dapat dilakukan adalah mengubah n-variabel bebas yang berkorelasi menjadi beberapa m-faktor sebagai variabel baru yang tidak saling berkorelasi dengan n<m.

Ada beberapa contoh penelitian yang menggunakan analisis faktor :

- Dalam pemasaran untuk mengidentifikasi karakteristik pelanggan yang sensitif terhadap harga.

- Dalam manajemen SDM untuk mengidentifikasi faktor-faktor yang mempengaruhi produktivitas karyawan.

- dll

Langkah-langkah dalam analisis faktor, yaitu :

1. Merumuskan masalah

Meliputi :

- Tujuan analisis faktor harus diidentifikasi

- Variabel yang digunakan berdasarkan teori dan penelitian sebelumnya dan pertimbangan peneliti.

- Pengukuran variabel berdasarkan skala interval atau rasio.

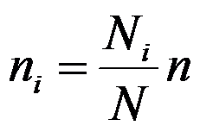

- Banyaknya elemen sampel (n) harus cukup memadai. Sebagai petunjuk kasar, jika ada k variabel maka n = 4k.

Pengujian untuk hal ini dilakukan dengan menggunakan statistik KMO (Kaiser-Meyer-Olkin) yaitu untuk mengukur kecukupan sampling. Nilai KMO yang kecil (<0,50) menunjukkan bahwa korelasi antar-pasangan variabel tidak bisa diterangkan oleh variabel lainnya dan analisis faktor tidak mungkin tepat.

2. Menentukan bentuk matriks korelasi

Analisis faktor tepat digunakan jika ada korelasi antara variabel-variabel yang diteliti. Dalam hal ini matriks korelasi bukanlah matriks identitas. Sedangkan untuk menguji apakah analisis faktor tepat digunakan atau tidak maka digunakan pengujian "The Bartlett's test of sphericity".

Hipotesis ujinya adalah

Ho : matriks korelasi adalah matriks identitas (tidak ada korelasi antar variabel)

Ha : matriks korelasi adalah bukan matriks identitas (ada korelasi antar variabel)

Ho akan ditolak jika nilai signifikansi pada Bartlett's test adalah kurang dari 5%.

Artinya terdapat korelasi antar variabel dan model tepat digunakan dengan teknik analisis faktor.

3. Menentukan metode analisis faktor

Terdapat beberapa metode analisis faktor yang biasa digunakan yaitu :

- Principal Component Analysi Jumlah varian dalam data dipertimbangkan direkomendasikan jika banyaknya faktor harus minimum dengan memperhitungkan varian maksimum dalam data untuk dipergunakan dalam analisis multivariat lebih lanjut.

- Common Factor Analysis, direkomendasikan untuk mengenali atau mengidentifikasi dimensi yang mendasari.

3. Menentukan banyaknya faktor

Ada beberapa prosedur yang dapat dilakukan, yaitu :

- Penentuan apriori yaitu menentukan jumlah faktor berdasarkan pengalaman sebelumnya atau teori yang mendukung. Jumlah faktor langsung ditentukan sesuai dengan yang diharapkan.

- Berdasarkan nilai eigen (eigenvalues) yaitu berdasarkan besarnya sumbangan dari faktor terhadap varian seluruh variabel asli. Dan hanya faktor yang memiliki nilai varian lebih besar dari 1 yang akan dimasukkan dalam model.

- Berdasarkan Scree Plot yaitu suatu plot dari nilai eigen sebagai fungsi banyaknya faktor. Hasil eksperimen menunjukkan bahwa titik tempat di mana scree plot mulai terjadi, menunjukkan banyaknya faktor yang benar. Kenyataannya jumlah faktor dengan scree plot akan lebih banyak 1 daripada berdasarkan eigenvalues.

- Penentuan berdasarkan pada persentase varian. Petunjuk yang disarankan adalah ekstraksi faktor dihentikan jika kumulatif persentase varian sudah mencapai paling sedikit 60% atau 75% dari seluruh varian variabel asli.

4. Melakukan rotasi faktor dengan tujuan untuk mempermudah interpretasi faktor. Melalui rotasi faktor maka matriks faktor akan diubah ke matriks yang lebih sederhana. Dalam melakukan rotasi ada beberapa metode yang digunakan, yaitu orthogonal rotation dan oblique rotation.

Orthogonal rotation yang biasanya digunakan adalah varimax procedure yaitu berusaha meminimumkan banyaknya variabel dengan muatan tinggi pada satu faktor, sehingga memudahkan interpretasi faktor-faktor. Sedangkan oblique rotation digunakan jika faktor dalam populasi berkorelasi sangat kuat.

5. Melakukan interpretasi faktor. Akan lebih mudah dilakukan dengan mengenali/mengidentifikasi variabel yang muatannya (loadingnya) besar pada faktor yang sama. Dalam hal ini memberi nama dari faktor yang terbentuk.

6. Menghitung skor atau nilai faktor, hal ini dilakukan jika ingin melakukan analisis lanjutan. Seperti regresi yang mana faktor adalah hasil variabel yang tidak multikolinear, atau analisis multidiskriminan. Sedangkan jika kita hanya ingin mengidentifikasi faktor atau karakteristik maka hal ini tidak perlu dilakukan.

Metode component factor analysis tidak akan ada korelasi pada faktor-faktor yang dihasilkan. Sedangkan jika menggunakan common factor analysisi maka tidak akan menjamin bahwa faktor tersebut tidak akan berkorelasi. Menghitung faktor skor dapat dilakukan setelah model faktor dibentuk, yaitu :

Fi = wi1F1 + wi2F2 + wi3F3 + ... + wijXj + ... wikXk

Fi = skor (nilai) faktor ke-i

wi = bobot / koefisien faktor

k = banyaknya variabel

i = jumlah faktor

Timbangan atau bobot atau koefisien faktor wij digunakan untuk menggabung variabel yang dibakukan yang diperoleh dari factor score coefficient matrix.

7. Menentukan "Model Fit".

Reference :

- Sharma, Shubash, 1996. Applied Multivariate Techniques. John Wiley & Sons, Inc. Canada.

- Supranto, J., 2004. Analisis Multivariat : Arti dan Interpretasi. Rineka Cipta. Jakarta.