Uji asumsi klasik berikutnya adalah uji heteroskedastisitas. Dalam analisis regresi, salah satu asumsi yang harus dipenuhi adalah varians error masing-masing variabel bebas harus konstan. Hal ini dikenal dengan istilah Homoskedastisitas. Selain itu dikenal istilah Heteroskedasitas lawan dari Homoskedastisitas, yaitu keadaan dimana terjadinya ketidaksamaan varian dari error untuk semua pengamatan setiap variabel bebas pada model regresi.

Untuk menguji ada atau tidaknya Heteroskedastisitas dapat dilakukan melalui beberapa uji, yaitu :

- Uji Spearman's rho.

- Uji Glejser.

- Uji Park.

- Uji melalui pola grafik

Secara umum persamaan regresi linear berganda adalah

Y = a + b1X1 + b2X2 + error

Sedangkan Y prediksi atau mean Y adalah

Y' = E(Y) = a + b1X1 + b2X2

Untuk metode ke-4, melalui pola grafik, ada beberapa hal yang sering muncul, yaitu :

1. Jika data berdistribusi Poisson seperti jumlah hari sakit karyawan dalam sebulan. Maka pola grafiknya adalah :

2. Jika data berdistribusi Binomial, maka pola grafiknya adalah :

3.Jika data adalah data ekonomi dan bisnis biasanya adalah model multiplikatif (perkalian), sehingga fungsi regresi yang terbentuk adalah hasil perkalian antara Y' dengan error, yaitu Y = E(Y) * error = Y' * error

Maka pola grafiknya adalah sebagai berikut :

Ada beberapa indikator yang dapat menyebabkan terjadinya heteroskedastisitas, yaitu :

- Kesalahan input nilai dari variabel tidak bebas Y.

- Biasanya ada pada data Time Series dan data ekonomi.

- Adanya manipulasi data.

- Distribusi data yang tidak normal seperti Poisson dan Binomial.

Apa solusinya jika terjadi heteroskedastisitas?

- Menambah atau mengganti data sampel baru.

- Melakukan transformasi variabel bebas X terhadap variabel tidak bebas Y.

- Menggunakan metode estimasi yang lebih Advance seperti GLS (Generalized Least Squares) dan WLS (Weighted Least Squares)

- Menggunakan model regresi linear berganda dimana nilai residualnya mengikuti Autoregressive Conditionally Heteroscedastic orde 1 (ARCH(1) ) atau mengikuti Generalized ARCH(1).

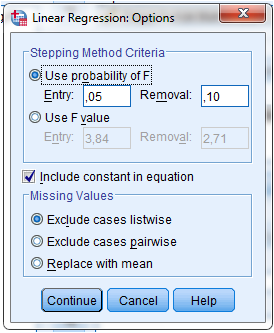

Next Session adalah contoh pengujian Heteroskedastisitas dengan IBM SPSS 21.

by MEYF

Referensi :

- Mendenhall, Sincinch. 1996. A Second Course In Statistics. Regression Analysis. Fifth Edition. Prentice Hall Internatiomal Edition.

- Priyatno, Duwi. 2010. Paham Analisa Statistik Data dengan SPSS. Mediakom. Yogyakarta.

- Sugiyono. 2009. Metode Penelitian Kuantitatif Kualitatif dan R & B. Bandung.

- Supranto, J. 2004. Analisis Multivariat : Arti dan Interpretasi. Rineka Cipta. Jakarta.

- Walpole, Ronald E. 1992. Pengantar Statistika Edisi ke-3. PT Gramedia Pustaka Utama. Jakarta.

- Shochrul dkk. Cara Cerdas Menguasai Eviews. Salemba Empat. 2011. Jakarta.