Sebelumnya kita sudah membahas sebagian mengenai analisis regresi linear. Dapat kita rangkum beberapa langkah dalam analisis regresi linear :

- Membuat bentuk model regresi linear

- Mengambil data sampel

- Gunakan data sampel untuk mengestimasi parameter model linear

- Tentukan distribusi dari random error dan estimasi parameter lain yang tidak diketahui dari distribusi tersebut.

- Uji kegunaan model secara statistik

- Ketika model sudah sesuai maka model dapat digunakan untuk memprediksi atau mengestimasi.

Dalam regresi linear berganda yang berbasis OLS (Ordinary Least Square), persyaratan statistik yang harus dipenuhi sebelum melakukan analisis regresi linear berganda yaitu disebut dengan uji asumsi regresi. Namun analisis regresi linear yang tidak berdasarkan OLS tidak memerlukan uji asumsi, seperti regresi logistik.

Secara umum, uji asumsi untuk regresi dapat dikelompokkan atas :

1. Uji asumsi dasar regresi

- Uji normalitas

- Uji linearitas

- Uji homogenitas

2. Uji asumsi klasik regresi

- Uji multikolinearitas

- Uji heteroskedastisitas

- Uji autokorelasi

- Uji normalitas

Tidak ada ketentuan urutan uji mana yang harus dilakukan terlebih dahulu. Uji asumsi regresi ini dilakukan agar hasil analisa regresi yang diperoleh lebih akurat. Jika terdapat salah satu asumsi yang tidak terpenuhi, maka ada kecurigaan bahwa analisis yang diperoleh kurang akurat, error yang besar, koefisien yang tidak minim, variabel bebas yang tidak terdeteksi sehingga bisa menyebabkan kesalahan interpretasi.

Untuk itu jika asumsi regresi tidak terpenuhi, dilakukan beberapa hal agar dapat memenuhi uji asumsi tersebut, sebagai contoh uji normalitas, jika tidak terpenuhi maka salah satu solusinya adalah menambah jumlah sampel atau melakukan transformasi variabel, dll. Dan jika asumsi dasar masih tidak terpenuhi maka selanjutnya adalah mengubah analisis data regresi dengan analisis data yang lain yang dianggap lebih tepat.

Uji Normalitas (Test of normality) digunakan untuk mengetahui apakah populasi data berdistribusi normal atau tidak. Biasanya digunakan untuk data berskala ordinal, interval atau pun rasio. Uji yang biasa digunakan adalah uji Liliefors melalui nilai pada Kolmogorov Smirnov. (See this Uji Liliefors)

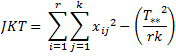

Uji Linearitas (Test of Linearity) digunakan untuk mengetahui apakah dua variabel mempunyai hubungan yang linear atau tidak secara signifikan. Pada SPSS diperoleh melalui ANOVA dengan memilih icon "Test for Linearity".

Uji Homogenitas (Test of Homogenity) digunakan untuk mengetahui apakah beberapa varian populasi data adalah sama atau tidak. Pada SPSS diperoleh melalui ANOVA dengan memilih Test of Homogenity, dan hasilnya bisa dilhat dari nilai Levene Test dimana semakin kecil nilainya maka semakin besar homogenitasnya.

Uji Multikolinearitas (Test of Multicolinearity) digunakan untuk mengetahui ada atau tidaknya hubungan linear antar variabel independen dalam model regresi. Pada SPSS diperoleh melalui Linear Regression dengan memilih icon Collinearity diagnostics, dan hasilnya ada pada kolom VIF yang memiliki nilai kurang dari 5 maka tidak terdapat multikolinearitas.

Uji Heteroskedastisitas (Test of Heteroskedasticity) digunakan untuk mengetahui ada atau tidaknya ketidaksamaan varian dari residual pada model regresi. Pada SPSS diperoleh melalui Bivariate Correlation.

Uji Autokorelasi (Test of Autocorrelation) digunakan untuk mengetahui ada atau tidaknya korelasi antara satu residual pengamatan dengan residual pengamatan lainnya pada model regresi. Pada SPSS diperoleh melalui Linear Regression dengan memilih icon Durbin-Watson.

Dalam regresi linear ada empat asumsi yang harus dipenuhi (see this Analisis Regresi Sederhana), yaitu :

- Masing-masing variabel bebas adalah linear dan tidak berkorelasi.

- Random error memiliki variansi konstan.

- Random error saling bebas (independen).

- Random error memiliki distribusi normal dengan mean 0 dan standar deviasi tetap.

Masing-masing asumsi dapat diuji dengan uji asumsi klasik di atas, yaitu

- Asumsi 1 : Uji normalitas

- Asumsi 2 : uji heteroskedastisitas

- Asumsi 3 : Uji autokorelasi

- Asumsi 4 : Uji multikolinearitas

Untuk selanjutnya akan kita bahas satu-persatu.

Semoga bermanfaat ;)

by MEYF

Referensi

- Mendenhall, Sincinch. 1996. A Second Course In Statistics. Regression Analysis. Fifth Edition. Prentice Hall Internatiomal Edition.

- Priyatno, Duwi. 2010. Paham Analisa Statistik Data dengan SPSS. Mediakom. Yogyakarta.

- Sugiyono. 2009. Metode Penelitian Kuantitatif Kualitatif dan R & B. Bandung.

- Supranto, J. 2004. Analisis Multivariat : Arti dan Interpretasi. Rineka Cipta. Jakarta.

- Walpole, Ronald E. 1992. Pengantar Statistika Edisi ke-3. PT Gramedia Pustaka Utama. Jakarta.

- Shochrul dkk. Cara Cerdas Menguasai Eviews. Salemba Empat. 2011. Jakarta.

- Shochrul dkk. Cara Cerdas Menguasai Eviews. Salemba Empat. 2011. Jakarta.